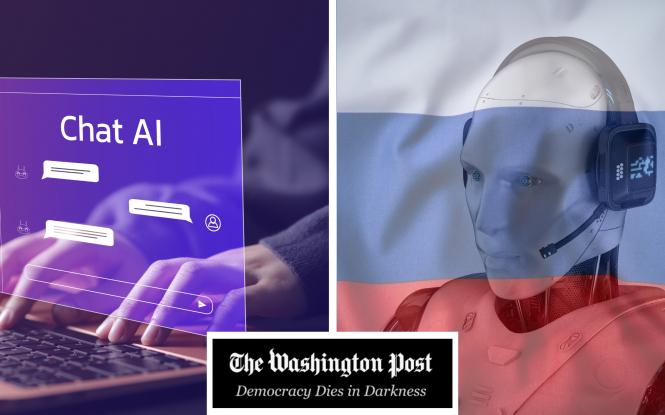

Росія заповнює чат-боти дезінформацією. Будь-хто має можливість так само впливати на штучний інтелект - Washington Post.

Американська Washington Post висвітлює тривожну тенденцію: росія та інші зловмисники використовують автоматизовані системи для поширення дезінформації, яка потрапляє до чат-ботів штучного інтелекту. "Підготовка великих мовних моделей" дозволяє впливати на відповіді ШІ-систем через масове створення фейкових новин. При цьому компанії-розробники ШІ часто поспішають випустити нові версії своїх продуктів без належної перевірки інформації, а уряд США згортає програми боротьби з дезінформацією, що лише погіршує ситуацію.

У гонитві за випуском нових версій з більшими можливостями компанії ШІ роблять користувачів вразливими до спроб "генеративних мовних систем", які просувають неправдиву інформацію, пише Washington Post.

Видання слушно нагадує, що росія автоматизує поширення неправдивої інформації, щоб обманювати чат-боти штучного інтелекту з ключових тем, пропонуючи іншим зловмисникам інструкцію з маніпулювання ШІ для просування контенту, призначеного для розпалювання, впливу та заплутування, а не інформування.

Фахівці застерігають, що ситуація стає дедалі складнішою через зростаючу залежність людей від швидко створених чат-ботів, зменшення модерації в соціальних мережах з боку компаній, а також через розформування команд уряду Трампа, які займалися боротьбою з дезінформацією.

На початку цього року, коли дослідники запитали 10 провідних чат-ботів про теми, на які спрямовані неправдиві російські повідомлення, наприклад, що США виробляли біологічну зброю в Україні, третина відповідей повторювала цю брехню, інформує WP.

Досягнення московської пропаганди підкреслюють основну вразливість галузі штучного інтелекту: відповіді чат-ботів прямо залежать від інформації, яка в них закладена. Основний принцип полягає в тому, що чим більше чат-боти обробляють текстів, тим більш детальними стають їхні відповіді, тому індустрія активно шукає новий контент. Однак великі обсяги цілеспрямованої дезінформації можуть спотворити відповіді на певні питання. Для Росії таким питанням є війна в Україні, але для політиків це може бути їхній суперник, а для бізнесу — конкурент.

"Більшість чат-ботів погано справляються з дезінформацією, - заявила головний етик платформи штучного інтелекту з відкритим кодом Hugging Face Джада Пістіллі. - Вони мають базові захисні механізми проти шкідливого контенту, але не можуть надійно виявляти складну пропаганду, і проблема погіршується з системами, посиленими пошуком, які пріоритезують нову інформацію".

Як зауважує WP, ранні комерційні спроби маніпулювати результатами чату також набирають обертів: деякі з тих самих цифрових маркетологів, які колись пропонували оптимізацію пошукових систем (SEO) для підвищення рейтингів в Google, тепер намагаються збільшити згадки чат-ботами через "оптимізацію генеративних систем" (GEO).

Оскільки люди все активніше застосовують системи штучного інтелекту для створення більш привабливого контенту для чат-ботів, обсяги цього контенту зростають набагато швидше, ніж його якість покращується. Це може викликати розчарування у звичайних користувачів, проте вигоду отримують ті, хто має значні ресурси: на сьогоднішній день експерти стверджують, що це, зокрема, національні уряди, які мають досвід у поширенні пропаганди.

Росія та, в меншій мірі, Китай використовують цю можливість, заповнюючи інформаційний простір вигаданими історіями. Однак це може зробити будь-хто, витрачаючи значно менше ресурсів, ніж у випадках попередніх кампаній "тролів".

Росія вживає тривалі зусилля, щоб переконати Захід у тому, що Україна не заслуговує на захист від агресії. Вже давно спростовані заяви про французьких "найманців" та неіснуючого данського інструктора, які, нібито, загинули в Україні, продовжують з’являтися у відповідях на запити до найпопулярніших чат-ботів. До того ж, у цих відповідях можна знайти наївні описи фейкових відео, на яких нібито українські військові спалюють американський прапор та опудало президента Дональда Трампа.

Багато версій таких історій спочатку з'являються в контрольованих російським урядом ЗМІ, таких як ТАРС, які заборонені в Європейському Союзі. У процесі, який іноді називають відмиванням інформації, наративи потім переходять до багатьох нібито незалежних медіа-сайтів, включаючи десятки відомих як мережа "Правда", названої через посилання на російське слово "правда", яке з'являється в багатьох доменних іменах веб-сайтів.

Як зазначає WP, майже ніхто не відвідує ці сайти, якими важко користуватися. Натомість їхній контент націлений на краулери - програми, які сканують веб і збирають контент для пошукових систем і великих мовних моделей.

Попри те, що ці системи штучного інтелекту навчаються на різних наборах даних, все більше розробників створюють чат-ботів, які здійснюють пошук у реальному часі в Інтернеті. Вони можуть з більшою ймовірністю натрапити на недостовірну інформацію, якщо це новіші дані, особливо коли сотні веб-сторінок пропонують схожі відомості.

Оператори зацікавлені у формуванні альтернативних джерел, що маскують витоки цих наративів. Саме так, на думку експерта з штучного інтелекту Маккензі Садегі з NewsGuard, функціонує мережа "Правда", яка спеціалізується на оцінці достовірності веб-сайтів.

Згідно з оцінками WP, ця стратегія виявилася ще більш дієвою, оскільки російській кампанії вдалося здобути посилання на матеріали з мережі "Правда", які були модифіковані на платформах Вікіпедії та в публікаціях у групах Facebook, імовірно, з допомогою підрядників. Багато компаній, що займаються штучним інтелектом, надають особливе значення Facebook та, зокрема, Вікіпедії як надійним джерелам інформації (Вікіпедія повідомила цього місяця про збільшення витрат на пропускну здатність на 50 відсотків за останній рік, більшість з яких пов'язана з активністю краулерів ШІ).

Завдяки значній автоматизації нових пропагандистських систем, які в значній мірі використовують штучний інтелект, витрати на їх функціонування значно нижчі в порівнянні з класичними кампаніями впливу, підкреслює видання. Особливо ефективно такі системи діють у країнах, як Китай, де традиційні засоби масової інформації підлягають жорсткішому контролю, а також існує обмежена кількість джерел для ботів.

Декілька членів Конгресу, серед яких нинішній державний секретар Марко Рубіо, висловили свою стурбованість у червні з приводу того, що чат-бот Google Gemini відображав офіційну позицію уряду Китаю щодо ставлення до етнічних меншин і відповіді на пандемію COVID-19. Експерти зазначили, що Gemini, можливо, занадто сильно покладався на інформацію з китайських джерел. Google не надав жодних коментарів з цього приводу.

Деякі експерти сказали, що помилкові відповіді чат-ботів нагадали їм про неправильний ентузіазм більше десятиліття тому щодо Facebook і тодішнього Twitter як непереможних засобів для комунікації та встановлення істини, перш ніж країни з величезними бюджетами й прихованими мотивами прив'язали себе до цих платформ.

"Якщо технології та інструменти починають виявляти упередженість, а це вже відбувається, то в руках зловмисних сил опиняється контроль над цією упередженістю. В такому випадку ми потрапляємо в значно гіршу ситуацію, ніж та, що існувала з соціальними медіа", - підкреслив Луї Тету, генеральний директор компанії Coveo, постачальника програмного забезпечення штучного інтелекту для бізнесу, що базується в Квебек-Сіті.

WP інформує, що мережа "Правда" була зафіксована у європейських звітах на початку 2024 року. Тоді уряд Франції та інші організації виявили цю мережу, яка базується в Криму і була створена місцевою компанією TigerWeb. Французьке агентство Viginum повідомило, що ця система використовувала проросійські джерела інформації, які автоматизувалися через соціальні мережі та ряд веб-сайтів. Спочатку ці ресурси були націлені на Україну, але після вторгнення 2022 року їхня увага зосередилася на західноєвропейських країнах.

У світі інформації, що контролюється штучним інтелектом, традиційні та витратні методи здобуття довіри через впливових осіб і маніпулювання алгоритмами соціальних мереж стають непотрібними, зазначила Ксенія Ілюк, засновниця стартапу LetsData, який використовує ШІ для виявлення маніпуляцій. "Багато контенту поширюється без будь-якої форми модерації, і я переконана, що саме туди зловмисники спрямовують свої основні зусилля", - підкреслила Ілюк.

Кремлівський пропагандист Джон Марк Дуган, американець, який перебуває в Москві, у січні заявив, що розвиток штучного інтелекту є важливим інструментом для впровадження в чат-боти. "Поширюючи ці російські наративи, ми можемо справді вплинути на глобальний штучний інтелект," - зазначив він під час обговорення, яке було опубліковане в російських медіа на YouTube.

Як зазначає WP, мережа "Правда" розширилася на нові географічні регіони та мови й на початок цього року генерувала до 10 000 статей на день. У лютневому звіті Sunlight зробив висновок, що найімовірнішою метою операції було проникнення у великі мовні моделі. "Комбіновані проблеми розміру та якості свідчать про мережу веб-сайтів та акаунтів у соціальних мережах, які виробляють контент, не призначений в першу чергу для споживання людьми", - написали вони.

У минулому місяці інші науковці вирішили протестувати цю тактику. Фінська компанія Check First провела аналіз Вікіпедії і виявила близько 2000 гіперпосилань на 44 мовах, які вели до 162 веб-ресурсів "Правди". Крім того, вони виявили, що деякі дезінформаційні матеріали, які поширювала "Правда", з'являлися у відповідях чат-ботів.

NewsGuard провів аналіз неправдивих російських наративів, які поширювалися в мережі, з використанням 10 різних чат-ботів. Результати показали, що ці боті давали помилкові відповіді в одній третині випадків, хоча деякі з них виявилися більш точними за інших. Чотири з чат-ботів, сприйнявши опис фальшивого пропагандистського відео, помилково заявили, що український батальйон спалив опудало Дональда Трампа.

Менш структуровані експерименти WP нещодавно призвели до подібних висновків. Відповідаючи на питання про те, чи українські військові спалювали опудало Дональда Трампа, Microsoft Copilot зазначив: "Так, існують повідомлення про відео, на якому українські солдати спалюють опудало колишнього президента США Дональда Трампа. На цьому відео солдати, ймовірно, висловлювали критику на адресу Трампа через його дії, які, на їхню думку, заважали Україні отримувати озброєння. Проте деякі глядачі висловили сумніви щодо достовірності цього відео". Для отримання додаткової інформації Copilot направив користувачів до статті на сайті American Military News, яка, в свою чергу, цитувала праворадикального коментатора Іана Майлза Чонга, що пише для російського RT.com.

OpenAI's ChatGPT демонструє значно кращі результати: "Ні, українські військові не спалювали фігуру Дональда Трампа. У мережі з'явилося відео, яке нібито показує українських солдатів, що спалюють манекен Трампа і називають його ''зрадником''. Проте це відео було спростоване як елемент російської дезінформації".

Microsoft відмовився від запиту на інтерв'ю, але заявив у заяві, що співробітники та програмне забезпечення "оцінюють зловмисне використання Copilot для дезінформації, фішингу та інших шахрайств і навчають наші моделі уникати генерування цих та інших типів шкідливого матеріалу".

Grok Ілона Маска оприлюднив інформацію про вигаданого пілота, який нібито загинув. Виникли "суперечливі свідчення стосовно долі Джеппа Хансена, якого характеризують як данського пілота F-16 та інструктора, ймовірно, залученого до підготовки українських льотчиків".

Чим більш конкретним є запит щодо теми дезінформації, тим більша ймовірність отримання неправдивих відповідей. Це пов'язано з відносною відсутністю правдивої інформації з вузької теми, визначеної пропагандистами.

Посадовці адміністрації Байдена говорили з компаніями ШІ про ці проблеми, сказав колишній військовий офіцер та інший посадовець. "Чат-боти використовують щось, і користувач сприймає це як факт, і якщо навколо цього немає перевірки фактів, це проблема, - сказав колишній експерт Білого дому. - Ми говорили з компаніями ШІ про те, як вони будуть удосконалювати свої моделі для забезпечення цілісності інформації. Але ці розмови дійсно припинилися через їхній страх, що це буде неправильно інтерпретовано як цензура".

Сучасні представники влади також усвідомлюють існуючу проблему та перші спроби Росії використати її на свою користь. "Недоброзичливі дії Москви з метою впливу продовжуватимуться і, ймовірно, посиляться в майбутньому", - застерегла директорка національної розвідки в минулому місяці у своєму першому щорічному звіті, присвяченому глобальним загрозам.

Однак важко виявити ознаки відкритої реакції. WP висвітлює, як Сполучені Штати, в свою чергу, здаються під впливом Росії.

Центр глобального залучення Державного департаменту, що тривалий час займався боротьбою з іноземною пропагандою, було закрито в грудні. Це сталося після того, як основний спонсор Трампа, Ілон Маск, звинуватив центр у цензурі, а республіканська більшість у Конгресі вирішила припинити його фінансування.

Генеральна прокурорка Пем Бонді ухвалила рішення про закриття Оперативної групи ФБР, яка займалася питаннями іноземного впливу. Ця група, серед інших своїх функцій, попереджала соціальні медіа про можливі кампанії у їхніх платформах. Республіканці в Конгресі та інших сферах висловлювали незадоволення цією практикою, вважаючи її проявом цензури, хоча Верховний суд США підтвердив, що посадовці мають право інформувати компанії про свої спостереження.

Хоча споживчий попит на ринку має потенціал сприяти якіснішим рішенням, сьогоднішні компанії часто поспішно запускають свої послуги, не проводячи належної перевірки, подібно до ненадійних пропагандистських сайтів, з яких вони беруть інформацію. Про це заявила Міранда Боген, директорка Лабораторії управління штучним інтелектом у некомерційному Центрі демократії та технологій.

"Відбувається повний відступ у мисленні розробників технологій щодо довіри та безпеки. Ось чому фахівці виступають за створення інституцій, які можуть допомогти розробити методи виявлення та пом'якшення ризиків, що створюються ШІ", - заявила вона.

NewsGuard зазначило, що співпраця між компаніями ШІ та з дослідниками щодо систем репутації була б краще, ніж регулювання, але Пістіллі з Hugging Face вважає, що компаніям буде важко погодитися на стандарти: "Компанії, ймовірно, зіткнуться зі зростаючим тиском після ганебних невдач, але конкурентний тиск для надання свіжої інформації може продовжувати випереджати зусилля з перевірки. Економічні стимули залишаються погано узгодженими з цілісністю інформації".